Simplifier la mise en place du Big Data avec Pentaho

Quand on évoque la mise en œuvre d’une solution Big Data on est très rapidement confronté à un problème de compétences. Ces compétences sont diverses et portent aussi bien sur le framework hadoop que sur des compétences de développement Java ou bien encore sur des connaissances métiers que doivent posséder les data scientists dont on parle tant aujourd’hui.

On comprend mieux les hésitations de certaines entreprises si on ajoute à ces problèmes de compétence la complexité apparente d’une solution Big Data qui doit intégrer souvent de nombreux produits pour prendre en compte tous les aspects du BigData de la collecte des données jusqu’à leur visualisation sous forme de rapports ou de tableaux de bords.

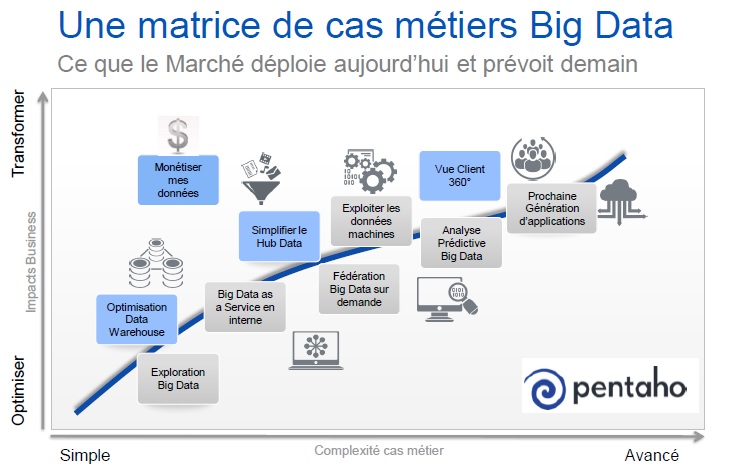

J’ai quant à moi entrepris de rencontrer l’écosystème d’hadoop pour comprendre quelles étaient les meilleures combinaisons face à différents cas d’usage. Le schéma proposé par Pentaho illustre les cas existants en gris et les nouveaux en bleu.

Les acteurs sont nombreux et il n’est pas toujours simple d’établir un positionnement clair d‘autant plus que l’écosystème hadoop évolue rapidement.

Ce matin c’est avec Pentaho que je discutais de problématiques de Big Data. Pentaho se positionne sur certaines phases d’un processus de Big Data à savoir :

- L’intégration des données

- La visualisation analytique

- L’analyse prédictive.

Sans rentrer dans le détail de l’offre Pentaho Je retiendrai de mon entretien avec S.Cognet et E.Brochard de Pentaho deux fonctions en particulier qui peuvent contribuer à simplifier la mise en place d’une solution de Big Data

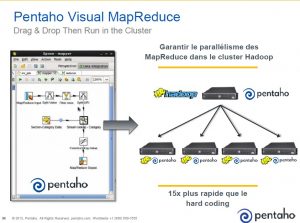

Avec cette fonction on peut s’affranchir de compétences de développement. Il est possible de développer des traitements MapReduce de manière graphique par simple Drag and drop sans compétences spécifiques Java. On reste ainsi sur des compétences analytiques auxquelles il faudra, bien sûr, rajouter des compétences d’administration Hadoop.

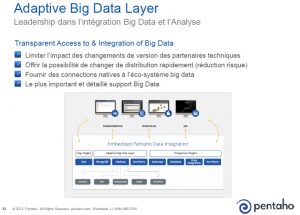

2- Adaptative Big Data Layer

On peut avec cette fonction s’adapter à toutes les distributions Hadoop

La fonction Adaptative Big Data Layer donne la possibilité de rejouer tout traitement MapReduce construit avec Pentaho sur n’importe quelle distribution Hadoop. Cela est possible grâce à une librairie Pentaho disponible pour chaque distribution Hadoop.

Encore tout dernièrement Pentaho a annoncé le support de la version Cloudera Enterprise 5.0 quasi simultanément avec l’annonce par Cisco de la validation de cette version avec l’architecture Cisco Common Platform Architecture intégrant des serveurs UCS.

Tags: