Rechenzentrum Daten-Forensik und Analytik

Die zunehmende Digitalisierung und Verarbeitung der Daten aus unterschiedlichen Clouds, Applikationen und Datenströmen wird den operativen Betrieb und die Verwaltung von Rechenzentren vor neue Herausforderungen stellen.

- Entsprechen die aktuell verarbeiteten Daten unserer Compliance und Sicherheitsrichtlinien?

- Welche Sicherheitsregeln werden für die jeweiligen Applikationen und Daten angewendet, sind diese aktuell?

- Welche physikalischen Abhängigkeiten zu Applikationen bestehen und welche Ressourcen werden zurzeit von den Applikationen konsumiert?

In meinem letzten Blog habe ich die Anwendung von Analytik Technologien in Rechenzentren und Cloud Infrastrukturen beschrieben, heute möchte ich deren Funktionsweise vertiefen.

Cisco hat mit Tetration Analytics ein innovatives, einzigartiges Konzept für die Koordination, Verwaltung, Optimierung und Überprüfen der Sicherheitsaspekte in der Datenverarbeitung für Rechenzentren entwickelt und geht damit neue Wege in der Daten Forensik und Analytik.

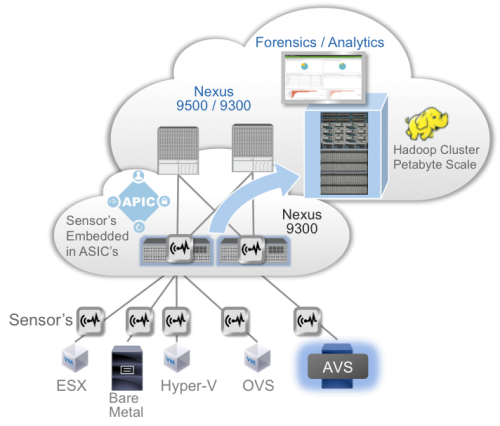

Herzstück des Konzeptes sind neu entwickelte Sensoren, das sind in ASIC Bausteine gegossene Analyse Algorithmen in der Nexus 9000 Linie welche die Datenströme ohne Performance Einbusse analysieren und ein Abstrakt der Daten an einen skalierbaren Hadoop Cluster weiterleiten. Auf diesem sind Daten Forensik- und Analyse-Werkzeuge installiert welche unterschiedliche Betrachtungen und Auswertungen der Daten in Echtzeit vornehmen.

Nebst den Nexus 9000 ASIC Sensoren werden ebenfalls hochentwickelte Sensoren für Virtual Machines (VM’s), HyperVisor’s, virtuelle Switches und Physikalische Server bereitgestellt. Diese sind optimiert und so konzipiert dass sie weniger als 0.3% der CPU Kapazität für die Analyse-Funktion konsumieren und so die Hauptaufgabe der Datenverarbeitung der Ressourcen nicht beeinträchtigen.

Abbildung 1 Forensik und Analytik Architektur

Automatische Erkennung von Applikationsabhängigkeiten und Kommunikationsmuster

Die Tetration Plattform ermöglicht die Erkennung verschiedener Anwendungen im Rechenzentrum und der Kommunikation zwischen Anwendungskomponenten durch maschinelles Lernen. Cluster aus Anwendungskomponenten (z. B. Datenbank-Cluster) können anhand von Kommunikationsmustern und Prozessinformationen automatisch erkannt und gruppiert werden. Mithilfe der Tetration-Echtzeittelemetrie werden die verschiedenen Anwendungsebenen (z. B. Web, Anwendung und Datenbank) zugeordnet, und es wird eine genaue Aufzeichnung der Anwendungsabhängigkeiten erstellt. Nach Beobachtung der Datenströme über einen längeren Zeitraum hinweg kann die Tetration Plattform Richtlinien (z. B. zum Verwerfen, Annehmen und Umleiten) zur Vermittlung zwischen den verschiedenen Ebenen einer Anwendung generieren. Diese analysierten Richtlinien können sodann automatisch in der Infrastruktur umgesetzt werden.

Tetration Analytics unterstützt aber auch einen Modus, in dem Whitelist-Richtlinien simuliert und ihre Auswirkungen analysiert werden können, bevor die Richtlinien in den Produktionsinfrastrukturen zum Einsatz kommen.

Mit diesem Konzept und der integrierten Sensor-Technologie lassen sich bahnbrechende Neuerungen in der Verwaltung und Kontrolle sämtlicher Daten im Rechenzentrum erreichen:

- Application Dependency Mapping (ADM)- Es wird in Echtzeit erkannt, welche physischen und virtuellen Ressourcen von der jeweiligen Applikation genutzt werden.

- Compliance – real time Policy control- Es wird jederzeit in Echtzeit ausgewiesen welches die jeweiligen Policies und Sicherheitsregeln sind welche für eine jeweilige Applikation zeitlich angewendet werden.

- Compliance simulation- Neue, überarbeitete oder angepasste Policies können simuliert werden, damit wird erkannt ob eine Verletzung der Sicherheitsrichtlinien und/oder Compliance vorliegt bevor die Policies produktiv und operativ angewendet werden.

- Sicherheit: Threat detection- Gefahrensituationen wie Angriffe, die Verbreitung von Malware und Abnormitäten werden in Echtzeit erkannt, Gefahrenzonen werden automatisch erkannt und isoliert.

- Applikations-Sicherheit- Anwendungen und Daten zu schützen wird einfach gemacht. Die Sensoren, auf den Applikationsservern installiert, messen nicht nur eingehende und abgehende Datenströme zur Analyse, sondern sind gleichzeitig auch für die direkte Umsetzung der Richtlinien zur Segmentierung der Applikations-Ebenen zuständig und setzen die Vorgaben (Policies) um.

Der Weg zur “Intent based Cloud”

Tetration Analytics ermöglicht mit dem neuen Konzept von Maschinenlernen, Applikations-Eerkennung mit Verhaltensmuster-Analyse eine volle Einsicht in die Daten aus Blickwinkel Sicherheit/Compliance, verwendete Ressourcen und Abhängigkeiten. Richtlinien (Policies) werden automatisch erstellt und in der Infrastruktur umgesetzt, wahlweise mit oder ohne vorab durchgeführte Simulation und Impact-Analyse.

Die wesentlichen Informationen aus den Analysen können über mehrere Jahre gespeichert werden, damit ist auch die Trendanalyse sowie die Revisionsfähigkeit gewährleistet.

Mein nächster Blog gilt dem mit Analytik optimierten und automatisierten -, dem sogenannten Intent-based-Rechenzentrum.

Tags:- ACI

- Analyse

- Analytics

- Applikationen

- Clouds

- Digitalisierung

- Nexus

- Rechenzentrum

- Security

- Sensoren

- Tetration

- Tetration Analytics

1 Kommentare

Stefan, herzlichen Dank für den Blog und die einfache Darstellung was eine Intent basierte Cloud ist.