Eric Baldeschwieler CTO et co-fondateur de la société Hortonworks aura profité de l’été pour quitter sa société.

L’occasion de faire un retour en arrière sur la naissance d’Hadoop puisque Hortonworks est, avec Cloudera et MAPR, une des 3 distributions d’Hadoop les plus connues.

Il y a une dizaine d’année on ne pensait pas encore au big data mais plutôt au moyen d’améliorer les moteurs de recherche pour analyser les millions de pages du Web.

En Octobre 2003 Google publie un document sur son « Google File Système » un système de fichiers distribués pour des applications de manière intensive de larges volumes de données distribuées.

En décembre 2004 un autre document est publié par Google sur l’algorithme « Map Reduce » qui permet à de gros traitements d’être parallélisés sur d’importants clusters de serveurs.

A l’époque Doug Cutting travaillait sur Lucene et Nutch , deux produits Open Source dans le domaine des moteurs de recherche. Il voit l’intérêt des publications de Google pour étendre son produit Lucene au domaine des moteurs de recherche de très grande volumétrie. Mais pour être capable de traiter des millions de pages web, il faut des moyens en machines et en développeurs, c’est pourquoi Doug Cutting rejoint Yahoo en 2006 ou il rejoint l’équipe de Eric Baldeschwieler .

Les codes des produits Lucene et Nutch sont incorporés dans un nouveau projet Apache qui prend le nom de Hadoop…

Pour l’anecdote l’elephant jaune de Hadoop, est un clin d’oeil de Doug au petit éléphant en peluche de son fils…

Un an plus tard hadoop est utilisé quotidiennement par de nombreux groupes de recherches au sein de Yahoo.

En 2009 Doug Cuttings quitte Yahoo pour rejoindre Cloudera , une des grandes distributions de Hadoop fondée, par trois ingénieurs venant de Google,Yahoo et Facebook.

En 2011 Yahoo! et Benchmark Capital forment une spin off, Hortonworks, dont Eric Baldeschwieler prend la direction jusqu’à ce mois d’aout 2013.

Quant à la société MAPR elle a été cofondée par John Schroeder qui en est le CEO et par MC Srivas qui en est le CTO. Srivas a dirigé l’une des principales équipes d’infrastructure de recherche de Google dans laquelle on utilisait largement GFS, BigTable et MapReduce.

Srivas a été egalement l’architecte en chef de Spinnaker Networks (qui a été racheté par NetApp) et a apporté ainsi sa connaissance des systemes de fichiers distribues.

Depuis d’autres distribution de Hadoop ont suivi comme par exemple celles de EMC (Greenplum/Pivotal) et d’Intel.

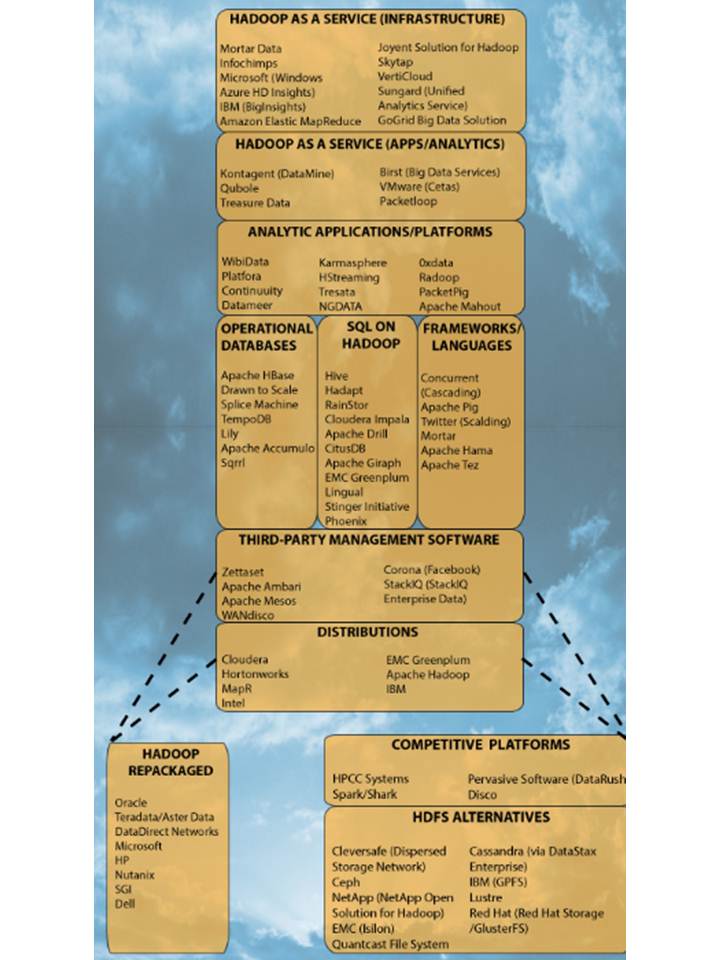

Hadoop est un large ecosystem que Gigaom a synthétisé dans The Hadoop ecosystem: the (welcome) elephant in the room (infographic) dont je reproduis l’illustration ci-dessous

A lire également :

- The history of Hadoop: From 4 nodes to the future of data publié par Gigaom

- Les effets de Hadoop sur l’infrastructure du datacenter

- Flexpod Select: une infrastructure convergée pour le Big Data

- Big Data : enjeux et compétences

- Optimisation d’un big data utilisant Hadoop chez Criteo avec les commutateurs Nexus

- Big Data : Une architecture Hadoop avec la distribution MapR et les serveurs Cisco UCS

- Intel annonce son Edition Hadoop supportée par les serveurs UCS de Cisco

- L’infrastructure de Big Data de Cisco supporte Pivotal HD de EMC