Cisco annonce Tetration Analytic pour analyser en temps réel le fonctionnement d’un datacenter

2 min read

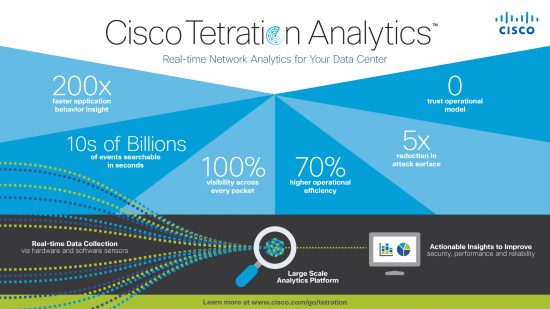

Contrôler finement le fonctionnement des datacenters devient un impératif dans notre monde numérique. En utilisant les dernières innovations technologiques basées sur des capteurs, du machine learning et du big data, la solution Cisco Tetration Analytics apporte la visibilité et l’analyse temps réel souhaitées.

Comment garder le contrôle d’un environnement IT de plus en plus complexe. Le CEO de Cisco Chuck Robin a lui-même pris la peine d’écrire un billet pour souligner l’importance cette annonce qu’il éclaire à la lumière de la transformation numérique qui touchera toute les entreprises. En 2018 65% des entreprises appartenant au « Global 2000 » auront mis cette transformation au centre de leur stratégie d’entreprise. Dans ce contexte le Datacenter jouera un rôle de plus en plus essentiel. Le numérique a envahi notre quotidien tout particulièrement avec les applications mobiles accessibles à tout moment sur notre smartphone. Ces nouveaux usages auxquels nous nous sommes habitués reposent sur le bon fonctionnement des Datacenters. Une tâche exigeante et complexe au vue de la prolifération des applications, de la mobilité des utilisateurs, de l’utilisation de cloud hybride et de la généralisation de la virtualisation. A titre d’exemple les nouvelles applications dites « cloud natives » sont devenues plus complexes. Chaque nouvelle application repose sur une architecture multi composants qui a pour conséquence d’augmenter le trafic Est Ouest qui représente à présent 75% du trafic d’un Datacenter.

https://www.youtube.com/watch?v=QAig2SLODuI

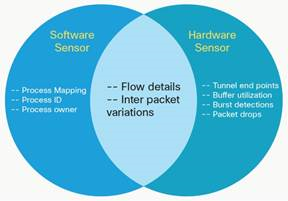

Le Machine Learning pour analyser rapidement et avec précision. Ils existent de nombreux outils qui proposent de répondre à ce besoin de visibilité mais rien qui permette d’avoir une approche globale cohérente, simple d’utilisation et adaptée aux nouveaux impératifs d’un datacenter moderne. La plateforme Tetration utilise une approche de machine Learning (système utilisant des algorithmes auto apprenants) qui permet de traiter des millions de flux par seconde et de fournir des informations prêtes pour déclencher une action en quelques minutes. En utilisant des capteurs matériels et logiciels, la plateforme collecte et stocke des centaines de millions d’enregistrements de mesure sans les agréger pour permettre des investigations sur du long terme. Tetration offre une visibilité complète des composants d’une application et de leurs dépendances qui facilite la mise en place d’un modèle « Zero Trust » dans le réseau. Un modèle qui part du principe que la confiance n’existe plus et qu’il faut bâtir des zones de sécurité en conséquence par des techniques de micro segmentation.

proposent de répondre à ce besoin de visibilité mais rien qui permette d’avoir une approche globale cohérente, simple d’utilisation et adaptée aux nouveaux impératifs d’un datacenter moderne. La plateforme Tetration utilise une approche de machine Learning (système utilisant des algorithmes auto apprenants) qui permet de traiter des millions de flux par seconde et de fournir des informations prêtes pour déclencher une action en quelques minutes. En utilisant des capteurs matériels et logiciels, la plateforme collecte et stocke des centaines de millions d’enregistrements de mesure sans les agréger pour permettre des investigations sur du long terme. Tetration offre une visibilité complète des composants d’une application et de leurs dépendances qui facilite la mise en place d’un modèle « Zero Trust » dans le réseau. Un modèle qui part du principe que la confiance n’existe plus et qu’il faut bâtir des zones de sécurité en conséquence par des techniques de micro segmentation.

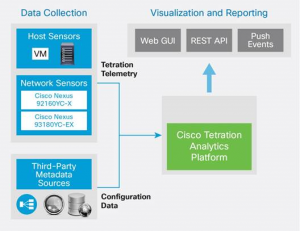

La plateforme Tetration Analytics est constituée de 3 couches fonctionnelles :

- La couche de collection de données: Ces sont les yeux et les oreilles de la solution et utilise des capteurs logiciels installés sur n’importe quel serveur physique ou virtuel et des capteurs physiques dans des Nexus 9000

- La couche analytique : La plateforme Big Data multi serveurs traite les informations provenant des capteurs en utilisant des technologies de machine learning

- La couche de visualisation : La plateforme permet d’utiliser les données à l’aide d’une interface web GUI et d’APIs (REST).

Des cas d’usages attendus par les responsables opérationnels. Cette solution devrait rencontrer un vif intérêt car les responsables des datacenters pourront dorénavant avoir :

- la visibilité applicative avec les informations sur les composants de l’architecture applicatives

- des recommandations de règles automatisées avec une analyse des impacts

- la conformité avec les règles et une auditabilité

- des possibilités de visualisation des flux, d’exploration et d’investigation