le Big Data et l’IoT ouvrent de nouvelles perspectives pour l’analytique

3 min read

« La donnée est la nouvelle ressource de l’économie numérique ». Le ministre de l’économie l’a rappelé le 9 novembre 2015 en présentant le projet de loi NOE (Nouvelles opportunités économiques). La donnée représente un capital stratégique et un levier économique pour les entreprises. Pour concrétiser ce potentiel cela impose de développer des approches d’infrastructures et d’analytiques adaptées à la diversité des sources de données. Une approche qui sera présentée par Cisco lors du salon « Big Data Paris » les 7 et 8 mars 2016.

En 2020, 40% des données proviendront de capteurs de toutes sortes. Il y a quelques années la quasi-totalité des données étaient des données structurées stockées dans les bases de données de centres informatiques. Avec l’avènement du numérique une multitude de données de tous types se sont créées hors du cadre de l’entreprise et conduit les solutions analytiques à s’adapter selon trois étapes :

- Analytique 1.0: Les données structurées proviennent des bases de données et sont analysées après avoir été préalablement copiées dans un entrepôt de données centralisé.

- Analytique 2.0: Les données non structurées s’amplifient et doivent être prises en compte par de nouvelles architectures comme Hadoop et les bases de données NoSQL pour les rendre accessibles aux outils analytiques.

- Analytique 3.0: Le développement des objets connectés (IoT) engendre une multitude de sources de données situées hors des centres informatiques. Ces nouvelles données représenteront 40% du total des données en 2020. Leur exploitation ouvre de nouvelles perspectives d’optimisation de processus industriels et de création de nouveaux services.

Les défis des nouvelles solutions analytiques. Le déluge des données, évoqué en 2010 dans la revue The Economist, a mis en évidence une formidable opportunité pour les entreprises. Le contexte économique et compétitif oblige les entreprises à plus d’agilité. Analyser, anticiper, optimiser et innover sont des objectifs qui seront d’autant plus facilement atteints que l’on sera capable d’exploiter facilement et rapidement les données. Pour cela les outils analytiques et les infrastructures qu’elles exploitent doivent :

- Exploiter les données en temps réel dès leur création. L’utilisation d’un entrepôt de données nécessite des opérations ETL (Extract, Transfert, Load) pour extraire les données des bases de données et les charger dans le datawarehouse. Le décalage entre le moment ou la donnée est produite et celui où elle est exploitée peut pénaliser la pertinence du résultat et la rapidité de la prise de décision. Les nouvelles solutions doivent exploiter en temps réel, et sans passer par des opérations intermédiaires, les informations contenues dans l’ensemble des bases de données (y compris le “data lake” si il existe) de toute l’entreprise.

- Faciliter l’accès aux données par des directions métier. Les utilisateurs des directions métiers ont besoin d’analyser rapidement et simplement des données appartenant à différentes bases de données. Cela devient possible si on leur offre le moyen de réaliser une vue logique de toutes les données nécessaires sans déplacement ou copie de données.

- Rapprocher les processus analytiques des sources de données. De plus en plus de données sont générées par des centres d’appels, des bornes wi-fi, des smarphones, des compteurs intelligents et plus globalement par tout objet ou équipement communicant. Transférer systématiquement toutes ces données vers un centre informatique centralisé peut s’avérer contre-productif. Certaines données sont rapidement obsolètes et d’autres ne supportent pas de temps de latence pour déclencher une action. Les outils d’analyse doivent pouvoir s’installer au plus près des sources de données.

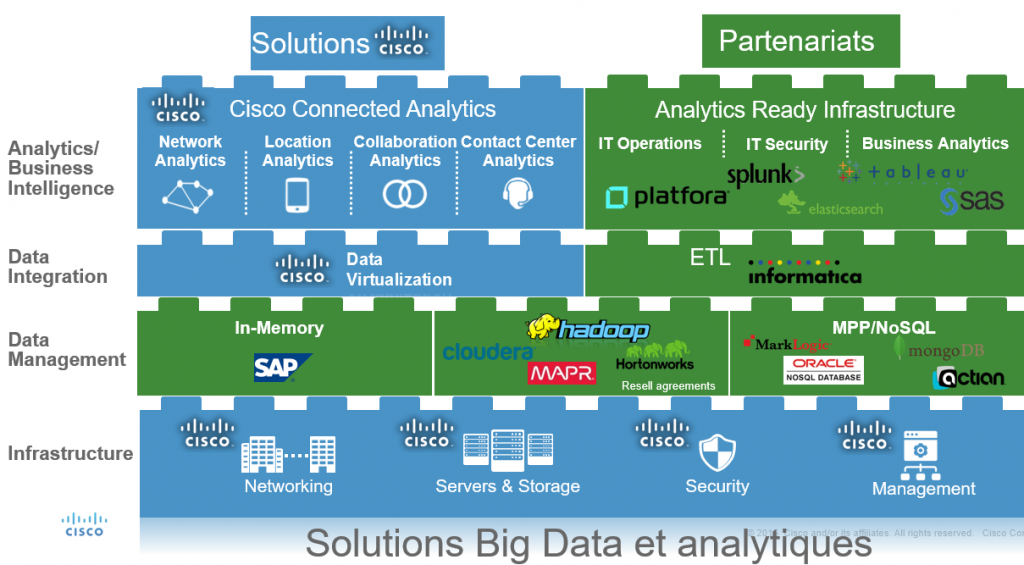

S’adapter aux enjeux des entreprises et à la typologie des sources de données. Pour répondre à ces enjeux Cisco a développé un ensemble de solutions qui couvre :

- Les besoins d’infrastructure : Cisco dispose d’une large gamme qui adresse les besoins des centres informatiques et du cloud en termes de serveurs, de réseaux, d’administration et de sécurité.

- La gestion des données: Dans le cadre du Big data, la gestion des données prend des formes différentes et souvent complémentaires comme le « In Memory », Hadoop, le MPP (massively parallel processing) ou le NoSQL. Pour chacune d’entre elles Cisco a noué des partenariats pour interfacer ses équipements. Fin 2015 Cisco a également procédé à l’acquisition de la société Parstream pour fournir des solutions MPP dans des environnements comportant des sources de données extrêmement distribuées.

- L’intégration de données : Pour améliorer l’efficacité des outils analytiques et simplifier la tâche de ceux qui les utilisent, la solution Cisco Data Virtualization permet de construire une vue logique et centralisée des données accessible simplement par un « portail business ».

- Les outils analytiques et de business intelligences. La gamme « Cisco Connected Data and Analytic » permet d’obtenir des informations pertinentes en temps réel sur l’ensemble de l’entreprise. L’offre recouvre des logiciels qui prennent en compte différents types d’architecture (réseaux, centres d’appels, collaboration) et des solutions analytiques pour adresser divers domaines tels que la grande distribution, les opérateurs telecom, l’industrie et d’autres encore.

Salon du Big Data Paris : Des experts seront à votre disposition sur le stand Cisco pour discuter de vos projets spécifiques dans les domaines du Big Data et de l’analytique. Vous pourrez également assister à des démonstrations et vous rendre compte par vous-même de l’intérêt des offres dans votre contexte. Vous pouvez vous inscrire dès aujourd’hui.

Salon du Big Data Paris : Des experts seront à votre disposition sur le stand Cisco pour discuter de vos projets spécifiques dans les domaines du Big Data et de l’analytique. Vous pourrez également assister à des démonstrations et vous rendre compte par vous-même de l’intérêt des offres dans votre contexte. Vous pouvez vous inscrire dès aujourd’hui.